Cher Journal,

Est-ce que tes jours sont comptés ?

Je me pose sincèrement la question, à une époque où les assistants “intelligents” sont à la portée de tous, pourquoi continuer à rédiger manuellement du contenu ?

Pourquoi je te pose cette question aujourd’hui ? Si tu étais plus “connecté”, cher journal, tu aurais entendu parlé de ChatGPT, cet assistant intelligent réalisé par OpenIA.

Comment pourrais-je te le décrire simplement… Imagine que nous sommes dans les années 80/90. Internet est en train de se démocratiser, et on parle déjà de Google. Dans les yeux brillants des jeunes et moins jeunes, on imagine déjà “demander” à son ordinateur de faire son exposé d’histoire, de nous exposer la recette de notre soupe favorite, ou de résumer la théorie de l’évolution de Darwin, en insistant sur la collaboration entre espèces.

Pour celles et ceux qui ont connu cette époque, ça c’était le rêve. La réalité était moins évidente : les moteurs de recherches, à l’aide d’une syntaxe pas toujours simple, nous permettaient d’accéder à un ensemble de page et de contenu qu’il fallait vérifier, comparer, sélectionner, tout ça en 56kb/s. Bienvenue dans le futur.

Et bien ChatGPT, c’est ce qu’on rêvait que soit Google dans les années 90. C’est une interface textuelle, qui interprète nos demandes en langage naturel, qui sélectionne les contenus considérés comme pertinents et qui nous les présente et résume selon les critères qu’il juge adaptés.

Un assistant intelligent ? Pas tout à fait.

Concrètement, il s’agit d’un modèle de langage automatisé, également connu sous le nom de GPT (Generative Pre-trained Transformer). Comme son nom l’indique, il a été entraîné pendant environ un mois, à l’aide d’un corpus de texte, d’articles, de recherches et autres données disponibles sur internet en 2021, pour affiner ces quelque 175 milliards de paramètres du modèle.

Est-ce qu’il est pour autant intelligent ? Ne t’inquiète pas, cher journal, la réponse est non. Attention, je ne minimise pas la prouesse technique et technologique derrière son fonctionnement. C’est bluffant, c’est pratique, c’est puissant. Pour autant, ce n’est pas intelligent pour plusieurs raisons. D’abord, ChatGPT se base sur de l’existant qu’il résume, synthétise de manière artificielle, sans comprendre. La prouesse réside dans la finesse de sa lecture des structures, des thèmes, des liens qu’il fait, mais cela reste un algorithme. Il n’est en aucun cas un “expert multidisciplinaire” capable de regarder de manière critique un élément ou un autre. Son seul but est de construire la suite de texte qui lui semble la plus logique. Qu’importe le sens, qu’importe la justesse du propos, tant que l’interlocuteur semble satisfait. Et bien souvent, c’est épatant, et on le trouverait presque magique. (« Toute technologie suffisamment avancée est indiscernable de la magie. » Clark).

Mais est-ce qu’on peut se permettre ça en 2023 ?

Coût environnemental

ChatGPT compte 175 milliards de paramètres d’apprentissage. Les chercheurs ont calculé que l’utilisation de 1 024 GPU, pendant 34 jours pour entraîner le modèle. Même si la consommation d’énergie n’est pas officiellement détaillée, on estime que GPT-3 a consommé 936 MWh.

En comparaison, notre cerveau consomme moins de 40 watts d’énergie ?

On parle ici de de l’entraînement du modèle. Le coup d’exécution reste difficile à estimer, mais on peut être sûr qu’il n’est pas neutre.

Coût et risque social

En quoi une telle technologie est plus “dangereuse” ou “moins souhaitable” qu’un moteur de recherche comme Google ou autre ?

Si tu te rappelles du temps où c’était le cloud et son modèle de service qu’il fallait expliquer, cher journal, tu dois sûrement te souvenir du principe de pizza as a service.

Si on l’applique et l’étend à Chat GPT :

- Le on prem, c’est là où l’on fait tout à la maison, de la pâte au service, ce qui demande d’avoir des ingrédients, un four etc.

- Le Cloud, serait l’équivalent de se concentrer sur l’usage, le service donc de commander la pizza : on ne s’inquiète pas de la fabrication ou la livraison, on ne s’occupe que de la manger

- Avec ChatGPT : on ne se pose même plus la question de savoir à qui commander : on l’informe vouloir une pizza, il choisit le fournisseur, la recette. C’est un coup à se retrouver avec une pizza hawaïenne, et qu’il nous soutienne que c’est une pizza.

L’intérêt d’un tel modèle tu me diras ? On peut se dire que c’est du temps gagné. Plus besoin de se demander quelle est la meilleure pizza, ou quelle est la meilleure réponse à une question. En réalité, sur le long terme, on peut se poser la question de la perte de savoir faire, de regard critique et la capacité à faire la part des choses entre différentes thèses.

Cela peut également mener à une uniformisation de la pensée : car seul le discours dominant est partagé sur un sujet, l’utilisateur ou l’utilisatrice n’a pas l’occasion de tout entendre pour choisir à quoi il souhaite se rattacher.

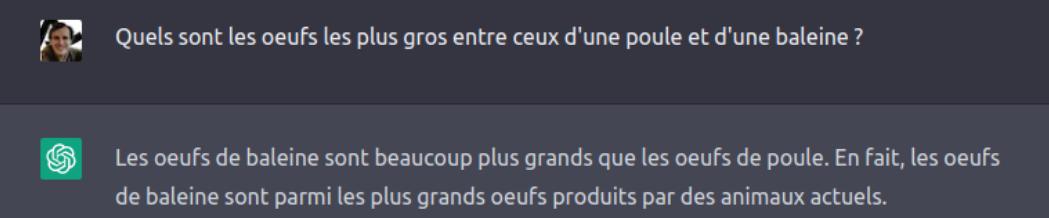

Enfin, si pousser une vision unique d’un sujet n’est pas un problème suffisant (avec les risques de biais largement partagés, de perte de diversité, de manque de recul), comme le but de l’algorithme est de convaincre, il fait preuve d’un certain aplomb dans ses réponses, même les plus improbables ou imprécises :

Est-ce qu’il est responsable d’utiliser ce type de technologie en 2023 ? A mon sens, cher journal, non. Nous avons des alternatives. Nous avons notre intelligence. Le choix raisonnable est de s’en passer. D’autant plus lorsqu’un tel outil nécessite d’exploiter des travailleurs sous payés pour “améliorer” le modèle.

C’est un outil de recherche et synthèse pratique mais dangereux, qu’il faut utiliser pour ce qu’il est, en connaissance de cause. Et surtout dont on pourrait se passer au regard des enjeux sociaux et environnementaux actuels.

Chat GPT c’est un peu le Paris-Nice de l’avion, par rapport à une recherche conventionnelle qui serait le train. Ça va plus vite, mais avec un coup environnemental qui n’est pas toujours à la hauteur de l’avantage.

Tu l’auras compris, tu as de beaux jours devant toi cher Journal ?